From-Scratch 사전학습으로 학습비용 1/12 절감…글로벌 모델급 성능 구현

트릴리온랩스가 독자적인 사전학습 방식으로 개발한 대규모 언어모델(LLM) ‘트리(Tri)-21B’를 오픈소스로 공개했다.

트리-21B는 단순한 텍스트 생성을 넘어 고차원적 언어 이해와 복잡한 문제 해결을 동시에 수행할 수 있도록 설계된 LLM이다. 전작인 트릴리온-7B 대비 파라미터 수를 3배 이상 확장한 약 210억 개 규모로 성능을 대폭 끌어올리면서도 1대의 GPU에서 원활하게 작동할 수 있는 경량성을 확보했다.

이번 모델의 핵심은 트릴리온랩스가 자체 개발한 ‘언어 간 상호학습 시스템(XLDA, Cross-lingual Document Attention)’이다. XLDA는 영어 기반 지식을 한국어 및 일본어와 같은 저자원 언어로 효과적으로 전이하는 데이터 학습 방법론으로, 기존 대비 1/12 수준으로 학습 비용을 절감했다.

이를 통해 데이터가 부족한 산업 분야에서도 LLM 활용도를 획기적으로 끌어올릴 수 있는 기반을 마련했다. 또한 한국어뿐 아니라 일본어와 같은 동북아 언어권에서도 더욱 자연스럽고 정확한 문장 생성이 가능하다.

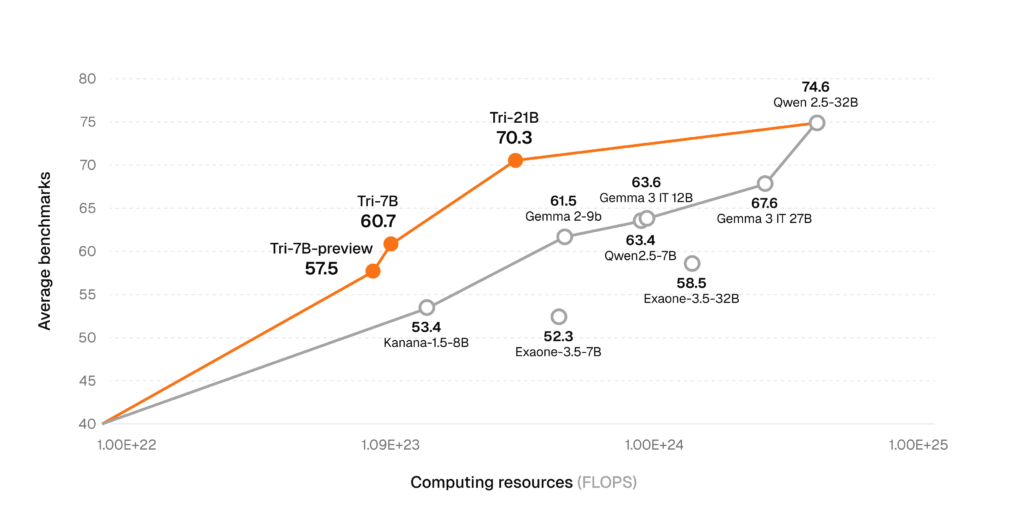

트리-21B는 종합지식(MMLU), 한국어 언어 이해(KMMLU), 수학(MATH), 코딩(MBPP Plus) 등 고난도 추론 중심 벤치마크에서 알리바바 Qwen 3, 메타 LLaMA 3, 구글 Gemma 3 등 글로벌 대표 중형 모델과 견줄만한 성능을 보였다.

특히 추론능력 검증(MMLU)에서 77.93점(CoT 적용시 85점), 수학(MATH)에서 77.89점, 코딩 영역(MBPP Plus)에서 75.4점의 정확도를 기록했다.

주요 한국어 벤치마크에서도 두각을 나타냈다. 한국문화의 이해도를 측정하는 해례(Hae-Rae)에서 86.62점, 한국어 지식과 추론능력(KMMLU)에서 62점(CoT 적용시 70점)을 기록해 글로벌 모델 대비 월등히 높은 점수를 달성했다.

신재민 트릴리온랩스 대표는 “트리-21B는 플라이휠 구조를 통해 70B급 대형 모델의 성능을 21B에 효과적으로 전이해 모델 사이즈와 비용, 성능 간 균형에서 현존하는 가장 이상적인 구조를 구현했다”고 설명했다.

신 대표는 “바닥부터 사전학습으로 개발한 고성능 LLM을 통해 비용 효율성과 성능 개선을 빠르게 달성하여 한국 AI 기술력의 완성도를 높이고, 향후 공개될 트리-70B와 함께 풀사이즈 LLM 포트폴리오를 완성해 나가겠다”고 밝혔다.

2024년 8월 설립된 트릴리온랩스는 한국어 중심 LLM을 독자적으로 설계하고 사전 학습부터 진행해온 스타트업이다. 2024년 9월 580만달러(약 90억원) 규모의 프리-시드 투자를 유치했으며, 2025년 3월 선공개모델 트릴리온-7B를 오픈소스로 공개한 바 있다.

Leave a Comment