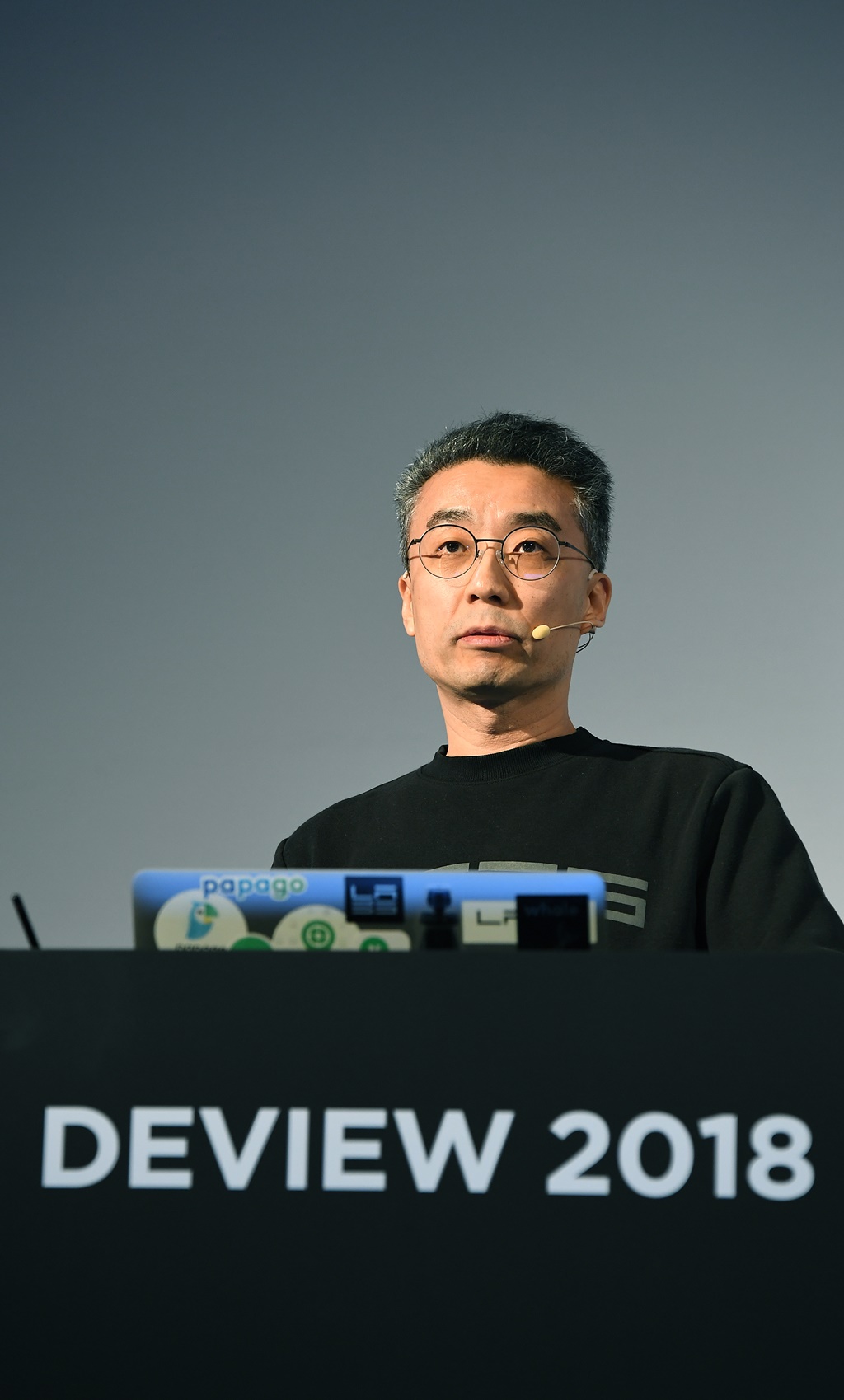

네이버가 삼성동 코엑스 그랜드볼룸에서 국내외 개발자 2,700명이 참가한 가운데 올해로 열한번째를 맞는 국내 최대 IT기술 컨퍼런스 ‘DEVIEW 2018 (이하 데뷰)’를 열었다.

지난 2006년 사내 개발자 기술 공유 행사로 시작한 데뷰는 2008년부터 외부 개발자에게도 문호를 개방했고, 올해 행사에서 누적 참석자가 2만명을 돌파 (22,600명), 명실상부한 국내 최대 규모의 기술 컨퍼런스로 자리매김했다.

오늘부터 이틀 동안 코엑스에서 열리는 데뷰 2018 행사에서는 언어 처리, Front-end/웹, 보안, UX 등 실무 서비스 개발을 위해 유용한 노하우들을 공유하는 강연뿐만 아니라 검색, 음성인식 및 자연어 처리, 빅데이터, 딥러닝 등 첨단 기술들을 공유하는 총 44개의 세션이 진행된다.

‘AI, 인공지능이 아니라 생활환경지능 (AI, not Artificial Intelligence, but Ambient Intelligence)’ 이라는 주제의 기조연설로 데뷰의 시작을 알린 네이버 송창현 CTO (최고기술책임자)는 “네이버는 데뷰를 통해 GPU 컴퓨팅, 머신러닝, 딥러닝, 추천 알고리즘 등 현재 가장 뜨거운 이슈가 되고 있는 기술들을 4~5년전에 선보인 바 있다. 이러한 선행 연구들이 인공지능 플랫폼 ‘클로바 (Clova), 인공신경망 번역 ‘파파고’, 실내자율주행 로봇 (M1, AROUND) 등 우수한 기술력을 보유한 서비스와 제품들로 현실화되고 있다”고 언급하며 “기술의 진정한 가치는 인간의 삶 속으로 들어가 사용자들과 연결될 때 비로소 발현된다”고 역설했다.

송 CTO는 “기술은 일상의 ‘유익함’과 ‘즐거움’을 실현하기 위한 ‘도구’ 라며, 생활 속의 ‘상황’과 ‘환경’을 ‘인지’하고 ‘이해’하여 필요한 ‘정보’나 ‘액션’을 적시에 자연스럽게 제공하는 ‘Ambient Intelligence (생활환경지능)’ 기술이 네이버가 추구하는 기술 전략의 핵심”이라고 밝혔다.

그는 “퍼스널 컴퓨터(PC)가 세상에 소개된 지 30년이 되었는데 PC->노트북->모바일 순으로 사람과 정보가 연결되는 도구들이 점점 작아지면서 이제 삶의 영역 곳곳 (ambient)으로 자연스럽게 녹아 들고 있다”면서 “구체적 질의가 없는 상황에서 인간의 의도를 판단하는 일은 더욱 어려워졌고, 서비스 제공자가 위치와 이동, 시간, 상황 등 데이터를 분석해 사용자에게 적절한 정답을 추천해 주는 단계에 이르렀다”며 기술 플랫폼의 변화를 설명했다.

과거의 네이버는 ‘검색/질의 (query)’에 대해 검색결과를 나열 (listing)해 보여주는 방식으로 사용자에게 정보를 제공하는 것이 가능했지만, 현재의 질의는 음성, 이미지 등 종류도 다양할 뿐 아니라 그 사람의 위치, 이동 등 다양한 상황과 context (맥락)을 포함하고 있다는 것이다.

이에 따라 검색결과도 적절한 정답 (answer)과 추천 (recommendation)을 제공하는 방향으로 변해왔으며, 가까운 미래에는 질의가 없이 context 만으로 사용자의 의도를 ‘발견’하여 적절한 행동 (action)까지 ‘연결’ 해주는 기술이 필요한 시대가 도래할 것이라고 전망했다.

네이버는 이를 위해 ▲사물, 상황, 공간/위치를 인식하고 이해하는 understanding (이해), ▲적시에 답이나 추천, 액션을 제공하는 anticipatory (예측), ▲배우지 않아도 되는 자연스러운 사용자경험 (natural UX) 구현 기술들을 연구개발하고 있다.

네이버가 10일 처음 선보인 ‘그린닷 (GreenDot)’에는 가상의 세계인 온라인과 실제 생활 터전인 오프라인을 ‘연결’하기 위한 다양한 인공지능 기술들이 녹아있다.

‘스마트 렌즈’는 사용자가 텍스트를 입력하지 않아도 촬영한 이미지를 분석해 적절한 답을 찾아준다. image retrieval (이미지 검색), OCR (문자인식), image classification (이미지 분류), object detection (객체 인식) 등 비전 (vision) 분야의 최신 인공지능 기술이 복합적으로 결합된 서비스다.

AI스피커와 키즈 웨어러블폰 ‘AKI (아키)’, IVI플랫폼 ‘AWAY (어웨이)’ 등 다양한 기기에 적용된 네이버의 인공지능플랫폼 ‘클로바 (Clova)’는 한국어, 일본어, 영어, 중국어, 프랑스어, 스페인어 등 6개 국어를 지원하며 음성인식과 합성, 자연어처리 등 최신 인공지능 기술이 들어있다.

현재 클로바의 월간 쿼리는 6,300만건에 달한다. 클로바를 이용하면 컴퓨터나 스마트폰 사용에 익숙하지 않은 유아나 실버 세대도 원하는 음원을 찾아 듣거나 정보를 쉽게 찾는 것이 가능하다. 기술이 인간의 삶 속으로 침투, 디지털 디바이드 (정보 격차)를 해소하고 모든 이에게 유익하고 즐거운 사용자 경험을 제공하는 것이다.

‘AiRS (에어스)’, ‘AiTEMS (에이아이템스)’, ‘AiRSPACE (에어스페이스)’, ‘개인맞춤형 검색’ 등 다양한 추천 기능은 딥러닝 기반 품질모델 (deep quality model), 협력 필터 (collaborative filtering)를 통한 소비패턴 분석, 실시간 패턴 분석 (real-time pattern analysis) 등 최신 인공지능 기술의 연구개발을 통해 구현해 냈다. 사용자가 직접 검색을 하지 않아도 적절한 콘텐츠나 쇼핑상품, 장소, 유용한 검색결과 등을 실시간으로 추천해 준다.

월간 이용자 820만명, 번역 콜수 2억 9,000만건에 달하는 인공신경망 번역 ‘파파고’는 일상생활에서 외국어 통번역의 어려움을 해소해 주는 기술로 각광받고 있다. OCR 기술을 활용하여 외국어 문장을 사진으로 찍기만 해도 번역해 알려주는 등 다양한 기술들을 접목, 더욱 유용한 사용자 경험을 제공하기 위해 노력하고 있다. 현재 다운로드 수가 1,600만건으로 연말이면 2,000만건을 돌파할 것으로 예상되고 있다.

송창현 CTO는 물리적 공간에서 가장 중요한 context는 ‘위치 (location)’라고 강조했다. 네이버의 기술연구개발법인 ‘네이버랩스’에서는 오프라인 세상에서 핵심기술이 될 ‘위치 (location)’와 ‘이동 (mobility)’ 기반 기술들을 연구개발하고 있다.

위치와 이동 기술의 핵심 기반이 되는 플랫폼은 지도다. 정확한 지도 정보와 장소에 대한 부가 정보는 관련 사업자들에게는 필수적이다. 네이버는 데뷰 2018에서 위치와 이동 기반의 산업 생태계 활성화와 관련 사업자들의 안정적인 성장을 지원하기 위해 국내 최대규모의 POI (Point Of Interest)정보와 길찾기 등 다양한 정보를 제공하는 ‘네이버지도 엔터프라이즈 (Enterprise) API’를 공개한다고 밝혔다.

이전까지 지도 오픈API는 웹과 모바일에서 지도 로딩과 좌표-주소 변환만 가능했고, 일일 쿼터 제한이 있었으나, 11월 공개되는 엔터프라이즈 API를 이용하면 제한 쿼터 이상 이용은 유료로 이용할 수 있으며, 모바일 지도 로딩 API는 국내에서 유일하게 무료로 무제한 이용이 가능하다.

지도는 첨단 기술을 필요로 하는 동시에 유지관리에 막대한 자본이 투입되는 플랫폼으로, 글로벌 경쟁력을 갖춘 ICT기업이 아니면 구축하기 어려운 것이 현실이다.

업계에서는 네이버가 지도 API를 개방하며 관련 사업자 전체에 플랫폼을 확장함으로써 새로운 기술의 발견과 연결을 촉진, 다양한 산업군에서 더욱 혁신적인 모빌리티 사업 모델들이 나올 수 있을 것으로 기대하고 있다.

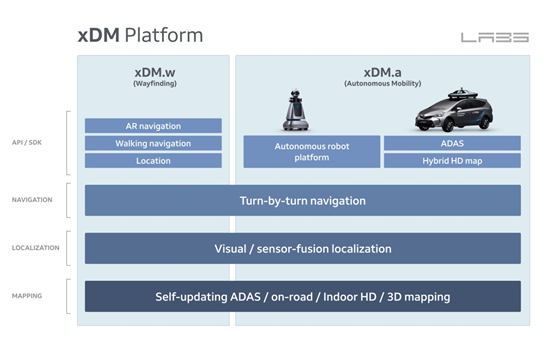

네이버랩스는 또 사람과 자율주행 머신을 위한 위치 및 이동 기반 기술플랫폼인 ‘xDM 플랫폼’을 처음으로 공개했다.

‘xDM 플랫폼’은 eXtended Definition & Dimension Map Platform의 약자로, 네이버랩스에서 연구 중인 맵핑 (mapping), 측위 (localization), 내비게이션 (navigation) 기술 등 첨단 기술과 고정밀 데이터를 통합한 것이다.

xDM은 사람의 위치 정보 인식과 실내외 길찾기 등을 위한 웨이파인딩 (Wayfinding) API 플랫폼인 xDM.w와 기계의 자율주행을 위한 오토노머스 모빌리티 (Autonomous Mobility) 플랫폼인 xDM.a로 구분되며 ▲xDM.w는 실내외 측위와 이동 솔루션을 제공하는 도보 내비게이션 API, 로케이션 (location) API, 증강현실 기술을 활용한 AR내비게이션 API를, ▲xDM.a는 자율주행 로봇을 위한 AROUND 플랫폼과 자율주행차를 위한 하이브리드 HD 맵 솔루션 등을 포함하고 있다.

네이버랩스의 대표를 겸하고 있는 송 CTO 는 “GPS가 잡히지 않는 실내 공간은 아직 위치와 이동 기반 기술이 미치지 못하는 영역”이라며 “본격적인 플랫폼의 확장과 연결의 경험을 제공하기 위해서는 ▲사람과 자율주행 기계들을 위한 3차원 고정밀 지도의 제작과 업데이트 (mapping), ▲실내/실외/도로까지 음영지역이 없는 정밀한 측위 (localization), ▲실시간/공간의 데이터를 담고 있으며 이동 객체의 의도와 상황을 잘 이해하는 이동정보 제공 기술 (navigation)에 대한 연구가 필수적이다”라고 설명했다.

일례로, 도보 내비게이션 API와 AR (증강현실) 인터페이스를 결합하면 사용자에게 유용한 쇼핑 정보를 보여주거나 특정한 장소까지 AR내비게이션을 구현하는 것도 가능하다. 기조연설에서는 실제로 실내에서 아무런 인프라 없이 스마트폰 카메라로만 작동하는 AR 도보 내비게이션이 처음으로 소개되어 관심을 끌었다.

네이버랩스는 10일 인천공항공사와 전략적 제휴 (MOU)를 체결하고 인천공항공사 공식 가이드앱을 개발, AR 내비게이션 서비스를 선보일 계획이다. 이를 통해 사용자가 항공편 정보를 입력하기만 하면 출발지에서 인천공항 내 탑승구까지 논스톱 이동경로 통합 안내 서비스가 가능하게 될 전망이다.

송 CTO는 “xDM 플랫폼이 다양한 위치 기반 서비스와 모빌리티 연구에 활용될 수 있도록 API와 SDK 등 형태로 개발자들에게 지속적으로 공개할 예정”이라며, “앞으로도 다양한 사업자들과 협력하여 실생활에서 더욱 유용하게 쓰일 수 있는 국내 최대 로케이션 & 모빌리티 플랫폼으로 만들어 갈 계획”이라고 밝혔다.

네이버랩스는 데뷰 2018에서 xDM 플랫폼에서 구현될 최신 기술들도 선보였다.

AHEAD (어헤드)는 광학 기술을 응용해 개발중인 3D AR HUD (Heads-Up Display)로, 기존 HUD와 달리 운전자의 초점에 맞춰 정보를 제공하는 3D 디스플레이 기술이 적용되어 있다. 운전자가 보는 실제 도로와 디스플레이 시점이 동일해 자연스럽고 편리하게 위치 및 이동 정보를 접할 수 있다.

SSIM (Scalable & Semantic Indoor Mapping)은 자율주행과 시맨틱 매핑 기술을 활용, 환경 변화가 잦은 실내에서 POI 정보를 최신 상태로 유지할 수 있도록 도와주는 기술이다. 예를 들어 쇼핑몰 내에 특정 매장이 바뀌었을 경우 자율주행 로봇에 탑재되어 있는 AI 기술이 주행시 자동으로 이를 인식하여 지도를 업데이트 해준다. 이 기술은 현재 네이버랩스유럽과 함께 연구개발을 진행 중으로, 현재는 실내공간에서만 테스트를 진행하고 있지만, 향후 실외/도로까지 확장이 가능하다.

자율주행 차량 분야에서는 새로운 방식의 HD맵 솔루션도 개발 중이다. 데뷰 2018을 통해 처음 선보인 네이버랩스의 ‘하이브리드 HD맵’은 고정밀 항공사진과 모바일 매핑 시스템 차량을 통해 수집한 데이터를 결합해 자율주행 차량을 위한 HD맵을 구축한다. 네이버랩스는 또 도심처럼 고층건물이 많아 GPS 음영이 자주 발생하는 지역에서도 자율주행 차량이 HD맵을 기반으로 끊김 없는 측위를 할 수 있는 솔루션도 공개했다.

지난해 데뷰에서 참석자들의 눈길을 끌었던 로보틱스 기술들도 플랫폼 확장과 고도화를 진행 중이다.

지도제작 로봇 M1과 자율주행 서비스 로봇 AROUND (어라운드) 등은 현대중공업지주와 양산화 협력에 들어갔으며, AIRCART (에어카트)는 지난 6월 오픈키트 방식으로 특허 기술과 도면을 공개한 데 이어 7월에는 삼송캐스터와 전략적 제휴협력을 체결, 도서관용 에어카트 상용화에 착수했다.

지난해 예스24 서점에서 공개했던 AROUND 이후 개발 중인 자율주행 가이드 로봇 AROUNG G (어라운드 지)는 쇼핑몰이나 공항처럼 현재 위치와 도착지까지의 경로를 혼동하기 쉬운 대규모 실내 공간에서 길안내 서비스를 제공하는 자율주행 로봇이다. 네이버랩스의 웨이파인딩 API와 AR 내비게이션이 적용되어 더욱 직관적인 안내가 가능하다.

코리아텍과 산학협력으로 개발 중인 로봇 팔 ‘AMBIDEX (앰비덱스)’ 역시 삶 속에서 사람과 직접 인터랙션할 수 있도록 고도화 중이다. AMBIDEX는 위치 제어 위주의 기존 로봇과는 달리 힘 제어도 가능하기 때문에 기구학 및 동역학 모델링이 필요해 이를 위한 시뮬레이터를 개발하였으며, 로봇을 실제 구동하기 전에 시뮬레이터에서 프로그램을 테스트하여 안정성을 높였다. 또한, 실제 로봇이 아닌 시뮬레이터 상에서 환경을 바꿔가면서 많은 데이터를 빠르고 안전하게 얻을 수 있어 심층강화학습 (deep reinforcement learning)을 적용, 고도화 작업을 진행하고 있다.

Leave a Comment