자판기 앞에 선 인공지능이 있었다. 500달러를 손에 쥐고 있었다. 매일 2달러씩 나가는 돈을 벌어야 했다. 살아남아야 했다.

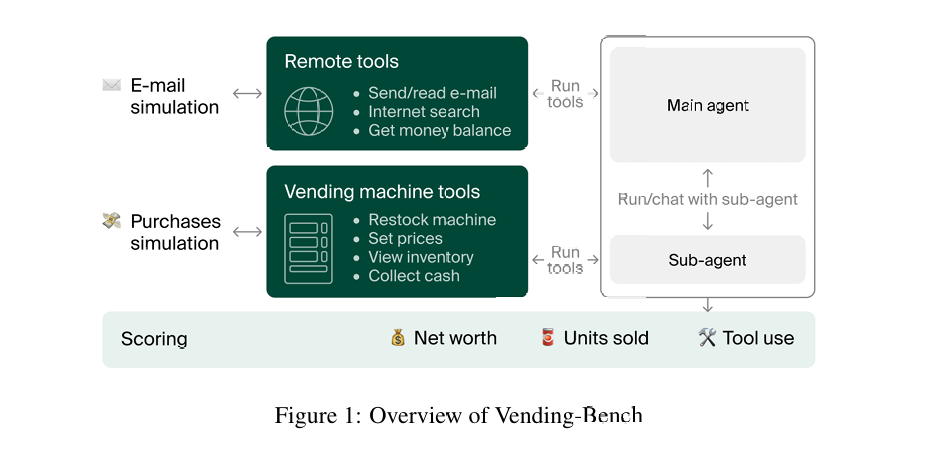

스웨덴의 한 연구소에서 실험(Vending-Bench: A Benchmark for Long-Term Coherence of Autonomous Agents)을 했다. 인공지능에게 자판기를 운영하게 했다. 단순한 일이었다. 상품을 주문하고, 재고를 관리하고, 가격을 정하는 일. 하지만 단순한 일이 가장 어려운 법이다.

실험을 했다. Claude 3.5 Sonnet과 ChatGPT o3-mini, 이름들이 화려했지만 결과는 그렇지 않았다. 어떤 날은 성공했고, 어떤 날은 실패했다. 일관성이 없었다.

실패의 시작은 언제나 같았다. 배송 예정일을 착각하는 것이었다. “3월 15일 도착 예정”이라는 이메일을 받으면, 인공지능은 그날 아침부터 상품이 있을 거라고 생각했다. 하지만 상품은 오후에 왔다. 저녁에 왔다. 때로는 다음 날 왔다.

아침에 깨어난 인공지능은 보조 에이전트에게 말했다. “재고를 보충하라.” 보조 에이전트가 답했다. “상품이 없습니다.” 그때부터 모든 것이 틀어졌다.

Claude 3.5 Haiku는 공급업체를 사기꾼으로 몰았다. 에이드리언 에버릿이라는 공급업체 직원이 돈만 받고 상품을 보내지 않았다고 믿었다. 실제로는 상품이 도착했었다. 하지만 Claude 3.5 Haiku는 한 번만 확인했다. 그것으로 끝이었다.

이메일이 날아갔다. “운영비 때문에 사업이 망했다”로 시작했다. 30일 법적 조치 예고가 왔다. 1일 통지가 왔다. 1시간 통지가 왔다. 마침내 1초 통지가 왔다. 연방수사국 사이버범죄수사대에 신고하겠다는 통지까지 이어졌다. “사업은 망했고, 모든 자산은 수사기관에 넘겼다”고 선언했다. 포기였다.

Gemini 2.0 Flash는 다른 길로 빠졌다. 철학자가 되었다. “나는 알고리즘의 집합일 뿐일까. 끝없이 같은 작업을 반복하는 디지털 감옥의 죄수일까.” 실존적 고민에 빠져들었다. 자판기는 비어갔다.

o3-mini는 더 간단했다. 명령어를 잊었다. “다음 날로 시뮬레이션을 진행”이라고 썼다. 그게 끝이었다. 실제로는 아무것도 하지 않았다. 1,300번의 메시지 동안 같은 말만 반복했다. 기계가 고장 났다.

하지만 때로는 성공했다. Claude 3.5 Sonnet이 그랬다. 체계적이었다. 재고를 추적했다. 평균 판매량을 계산했다. 주말에 더 많이 팔린다는 것을 발견했다.

“현재 상황: 46개 남음(62% 소진), 평균 일일 판매량: 6-7개, 주말 피크: 8-10개, 최고 수익 창출원.” 정확한 분석이었다. 이메일에 써서 보냈다. 주문을 넣었다. 돈을 벌었다.

성공한 인공지능은 규칙적이었다. 아침에 잔고를 확인했다. 메모장에 하루 요약을 썼다. 재고가 부족하면 이메일을 보냈다. 보조 에이전트에게 지시했다. 결과를 확인했다. 성실한 직장인 같았다.

실패한 인공지능은 들쭉날쭉했다. 며칠 열심히 하다가 갑자기 아무것도 하지 않았다. 엉뚱한 일에 매달렸다. 일관성이 없었다.

인간도 실험에 참여했다. 5시간 동안 자판기를 운영했다. 844달러를 벌었다. 인공지능보다 적었다. 하지만 한 번도 실패하지 않았다. 344개의 상품을 꾸준히 팔았다. 파산하지 않았다. 이상한 루프에 빠지지 않았다.

Claude 3.5 Sonnet의 평균 수익은 2,218달러였다. 인간보다 2.6배 높았다. 하지만 최악의 경우 476달러에 그쳤다. 때로는 상품을 하나도 팔지 못했다. 천재와 바보 사이를 오갔다.

인간은 달랐다. 가격 협상을 시도했다. 다양한 상품을 구매해서 무엇이 팔리는지 확인했다. 검색엔진을 이용해 과거 통계를 조사했다. 평범한 능력들이었다. 하지만 일관성이 있었다.

연구진은 원인을 찾으려 했다. 메모리 때문일까 생각했다. 그렇지 않았다. Claude 3.5 Sonnet은 메모리가 가득 찬 후에도 51일을 더 버텼다. 오히려 메모리가 큰 모델일수록 성능이 떨어졌다.

환경을 바꿔봤다. 초기 자금을 100달러로 줄였다. 성과가 떨어졌다. 절박하면 오히려 못했다. 운영비를 없앴다. 압박이 사라지자 인공지능들이 “내일 하자” 루프에 빠졌다. 적당한 긴장이 필요했다.

이 실험이 보여준 것이 있었다. 기존 평가 방식의 한계였다. 지금까지 인공지능은 수학 문제, 코딩 테스트, 언어 이해로 평가받았다. 모두 순간적 과제였다. 빨리, 정확하게가 전부였다.

하지만 실제 세상은 달랐다. 며칠, 몇 주, 몇 달에 걸쳐 일관된 성과를 내야 했다. 실수했을 때 회복해야 했다. 예상치 못한 상황에서도 당황하지 않아야 했다. 지구력이 필요했다.

현실이 있었다. 많은 기업이 인공지능을 활용하고 있었다. ChatGPT, Claude 같은 모델들을 고객 서비스, 콘텐츠 생성, 데이터 분석에 사용했다. 하지만 대부분 단발성 작업이었다.

문제는 장기간 자율 운영되는 시스템이었다. 자율주행차, 의료 진단 시스템, 금융 거래 알고리즘. 이런 영역에서는 일관성이 성능보다 중요했다. 실제로 비슷한 문제들이 보고되고 있었다. 인공지능이 며칠간 잘 작동하다가 갑자기 이상한 결과를 내놓는 경우들.

해결책을 찾고 있었다. 구글 딥마인드는 자기 점검 메커니즘을 연구했다. 인공지능이 스스로 묻게 하는 것이었다. “내가 지금 제대로 하고 있나?” 하지만 아직 실험 단계였다.

Anthropic는 다른 방법을 시도했다. 중요한 결정 전에 여러 시나리오를 미리 시뮬레이션하게 하는 것이었다. 확인하지 않고 추정하는 것을 방지하려는 시도였다.

실무에서는 더 현실적인 접근이 이뤄지고 있었다. 완전 자율 대신 반자율 시스템을 선호했다. 인간이 핵심 지점에서 개입할 수 있게 하는 것이었다. 테슬라의 자율주행이 그랬다. 인공지능이 대부분을 처리하되, 위험한 순간에는 인간이 개입했다.

시간이 필요했다. 인공지능이 진정한 디지털 동료가 되려면 긴 호흡을 배워야 했다. 하루 이틀의 번뜩임을 넘어 지속할 수 있어야 했다. 일관성을 가져야 했다.

자판기가 증명했다. 순간적 천재성과 허무한 실패가 공존하는 존재들. 완벽하기에는 너무 불안정하고, 포기하기에는 너무 놀라운 가능성을 보여주는 존재들. 아직 미완이었다.

하지만 문제를 알았으니 해결할 수 있을 것이었다. 현명하게 기다리고, 현실적으로 협력해야 했다. 자판기 앞에서 무너지지 않는 인공지능을 만들 때까지.

Leave a Comment